Schéma directeur du système d’informations des fonctions support

Le 11 septembre 2017, le Club MOA a donné la parole à l’un de ses membres. C’est Marie Laure MICOUD, Responsable du département pilotage et support de la DSI de la Caisse des dépôts qui a traité le sujet suivant : Définition du Schéma Directeur du système d’informations des fonctions support.

1 Introduction

Le projet de structuration d’un schéma directeur des SI des fonctions support de la filière SI doit proposer une trajectoire de développement des systèmes d’information pour les années 2018 a 2022 sous une contrainte de planning très serré (juin à septembre 2017).

Les objectifs de ce schéma directeur sont de transformer les SI des fonctions support en une plateforme de services orientée-clients, communs au Secrétariat Général du Groupe, aux directions RH, Communication, aux fins de densification de la CDC.

Ces objectifs doivent également emporter dans la même démarche l’évaluation de l’intérêt de la mutualisation des « SI fonctions-support » entre les établissements ICDC et la DSI faisant suite à l’organisation du pilotage unique de la filière SI en matière opérationnelle et budgétaire.

Le département de Marie Laure MICOUD a été créé en 2016. Il est en charge des fonctions de pilotage de l’établissement public et des fonctions du GIE ICDC (ICDC = Informatique CDC).

Le schéma directeur a été décidé suite au dépassement des crédits limitatifs. Il était prévu un budget de xxx millions d’euros révisé à yyy millions. L’objectif global est donc de diminuer le coût des fonctions support pour redistribuer les ressources financières sur les métiers.

2 Le Groupe CDC

La Caisse des dépôts et consignations (créée en 1816) et ses filiales constituent un groupe public au service de l’intérêt général et du développement économique du pays. Ce groupe remplit des missions d’intérêt général en appui des politiques publiques conduites par l’Etat et les collectivités territoriales. Il peut exercer des activités concurrentielles.

Le Groupe est un important contributeur au budget de l’Etat auquel il a versé 1,6 Milliards d’euros au titre des résultats de l’année 2016.

Il est sous la surveillance et la garantie de l’autorité législative.

Le Groupe CDC emploie 6 000 personnes dont 700 au sein du GIE ICDC, en charge de l’informatique opérationnelle du Groupe.

Le GIE informatique du Groupe CDC, ICDC (Informatique CDC) comporte trois établissements : les « Études » (DEI), la « Production » (DPI) [qui travaillent pour la Caisse des Dépôts et pour les autres membres], ainsi que la « Direction Générale » (DG) qui porte les directions fonctionnelles et support et la direction générale du GIE.

3 Le Prestataire

M.L. MICOUD a choisi la société xxx. Cette société est spécialisée dans la transformation numérique. Elle met à la disposition de ses clients une expertise dans la construction et la réalisation des schémas directeurs.

4 Création de la DSI de l’établissement public (EP)

La DSI du Groupe CDC a été créée au 1er Janvier 2015 avec les objectifs suivants :

1. Rénover le dialogue entre la maîtrise d’ouvrage et les métiers

2. Renforcer la capacité de la filière SI à répondre aux attentes des métiers

3. Favoriser l’urbanisation des SI

4. Mieux maîtriser les risques et les coûts

5. Simplifier les processus décisionnels et la gouvernance

6. AméliorerlagestiondescarrièresdelafonctionSI

En suivants 3 principes clefs.

1. Unitédecommandement

2. Réaffirmationdurôled’ICDCdemaîtred’œuvrederéférence

3. Uneconduitedechangementaxéesurlacoopérationentreacteurs

Pour le GIE ICDC, les bénéfices attendus de la création de la DSI, sont les suivants :

- Des objectifs partagés pour la mise en œuvre du schéma directeur des SI et du PPO (Programme de Performance Opérationnelle).

- Dans une organisation structurée de la DSI, le rôle du maître d’œuvre informatique de référence est réaffirmé par le DSI, président d’ICDC depuis fin juin 2015.

- Clarification des relations DEI/DPI avec la DSI.

- Optimisation de la gouvernance :

- Dans le cadre de projets multi-métiers, DEI se retrouve parfois en situation de porter l’alignement des métiers. Dans le cadre de la mise en œuvre de l’organisation de la DSI par domaine, l’alignement, la coordination et la mise d’accord des métiers sera portée par la DSI.

- Amélioration de l’efficacité de la fonction SI reposant sur une relation de confiance entre le DSI et le DG d’ICDC :

- Le changement d’état d’esprit porté par la création de la DSI est de nature à créer un climat de confiance et de coopération entre MOA et MOE. Ce climat de confiance permettra de limiter les conflits d’expertise.

- L’amélioration de la compréhension mutuelle des contraintes et difficultés du métier MOA et du métier MOE permettra aussi l’identification de solutions transverses à la fonction SI.

- Amélioration de l’efficacité et consolidation du pilotage économique :

- Actuellement, le pilotage économique fait intervenir plusieurs acteurs la DPSI (Direction des Processus et des Systèmes d’Information), les MOA / métiers, DEI et DPI, le contrôle de gestion ICDC. Ce fonctionnement est matérialisé par des « reportings » multiples dont la mise en cohérence est très souvent source de tensions. La DSI permettra une simplification des modes de « reporting » et une meilleure prévision de l’activité. La DSI est organisée en 6 domaines fonctionnels et 4 fonctions d’appui.

5 Contexte et objectifs recherchés du Schéma Directeur SI des Fonctions Supports

5.1 Contexte

Marie Laure MICOUD a développé les points suivants :

La stratégie de densification de l’EP et les fortes attentes de la gouvernance

- Sur l’amélioration du pilotage économique

- Sur l’amélioration de la productivité des fonctions support

De 2010 à 2015, un investissement significatif dans les systèmes de gestion de base a été réalisé. En parallèle il y a eu un sous-investissement dans les autres SI, et notamment ceux du SGG (Juridique, immobilier. et Achats), ainsi qu’une accumulation de dettes techniques et fonctionnelles

L’analyse met en exergue la nécessité d’une accélération de la transformation numérique, le besoin d’un « environnement de travail numérique », la construction de la filière SI (PMSI) et l’opportunité d’une plus forte convergence EP / ICDC sur les SI Support.

5.2 Objectifs recherchés dans l’évolution des SI

L’amélioration de la performance économique (notamment des achats, des approvisionnements, des paiements et de la gestion immobilière et logistique, peu outillés)

L’amélioration du service aux collaborateurs, et la recherche d’une plus grande autonomie, via des approches « client interne », « plateforme de services », « self- service » et « guichet unique »

L’amélioration continue de la productivité, via la numérisation des processus et leur automatisation

La gestion en continu de la dette technique et la rationalisation du SI, notamment entre l’EP et ICDC

5.3 Vision stratégique

La stratégie définie oriente l’évolution des Systèmes d’Information des fonctions supports vers une plateforme de services. Cette plateforme cible 4 axes.

- Une plateforme collaborateurs

- Une plateforme grand public / open data

- Une plateforme fournisseurs / partenaires

- Une plateforme gestionnaire

6 Démarche d’élaboration du schéma directeur SI

La définition du schéma directeur SI est réalisée suivant une approche en 5 phases avec une attention particulière à la transformation numérique du métier et du SI de chaque fonction support.

L’équipe projet a travaillé conjointement avec la MOA dans la définition du SDSI afin de respecter les contraintes de délais liées au contexte de la CDC.

7 Analyse de l’existant

7.1 Aspects budgétaires

- La répartition des dépenses 2016 est la suivante (xx millions d’euros)

| RH | Achat, CTRL de gestion, budget | Immobiliers et environnement de travail | Juridique | Communication |

| xx% | xx% | xx% | x% | x% |

7.2 Aspects fonctionnels

7.2.1 Fonction Ressources humaines (RH)

- La part importante des dépenses RH est due en grande partie aux accords collectifs et conventions spécifiques CDC.

- Le système de gestion du temps aura coûté ~xM€ sur la période 2015-2017

- La part de transformation numérique est aujourd’hui modeste par rapport au budget total des projets RH : ~4%

7.2.2 Fonction Achat

- La part des dépenses de la fonction achat est essentiellement due à 2 systèmes et à la fragmentation applicative de la gestion des achats (~10 applications) avec cependant une couverture partielle de la fonction

7.2.3 Gestion de l’immobilier

- Un manque de visibilité sur l’ensemble du patrimoine applicatif

- Trop de projets trop petits et pas de regroupements dans des programmes marquants

- Des expérimentations digitales en cours pour améliorer les services à l’occupant mais dont la suite est peu instruite, plusieurs référentiels pour gérer les différents sites

7.2.4 Fonction juridique

- Un projet (~xM€ sur 3 ans) en cours dont on ne tirera la pleine valeur qu’après la mise en place d’une GED3

7.2.5 Fonction communication

- Le SI communication est majoritairement en mode SaaS, non intégré au SI CDC

- Il est nécessaire d’améliorer les « analytics » sur les sites internet/intranet (au moins 4 outils différents à ce jour), le pilotage de la performance de la communication et certaines compétences

7.2.6 Constats transverses aux fonctions support

- Beaucoup des projets de transformation numérique, orientés client, impacteront des « SI cœur » de plusieurs fonctions support

- La gestion du cycle de vie des applications n’est pas standardisée

- Beaucoup de progiciels sont fortement modifiés et adaptés aux spécificités CDC

- Les budgets de maintenance évolutive en 2016 de plusieurs applications sont supérieurs aux budgets des projets

8 Construction de la cible du schéma directeur

La cible se présente comme un bouquet de services qui favorise l’orientation client des fonctions support. L’objectif est une simplification des interactions avec les collaborateurs, les gestionnaires, les prestataires et le grand public.

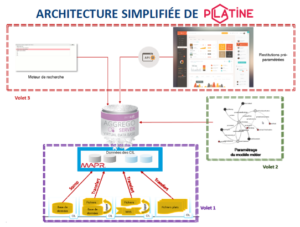

Le paysage technologique est segmenté en 3 familles de système pour s’aligner sur les besoins métiers et les opportunités technologiques

- Les systèmes d’engagement

- Les systèmes de pilotage

- Les systèmes cœurs

Déclinaison des axes du Schéma Directeur

- Réduire les dépenses sur le patrimoine applicatif existant en privilégiant les projets de transformation numérique

- Appuyer la plateforme cible sur un portail multicanal alimenté par des systèmes cœurs, d’engagement et de pilotage

- Automatiser / numériser les parcours des client transverses (ICDC devra mettre en place les éléments techniques de la plateforme numérique de la CDC)

- Améliorer le pilotage de la performance (Mise en place des outils de pilotage de la performance des Fonctions Supports en s’appuyant sur le socle BigData / Analytics déjà mis en place par ICDC)

- Implémenter les initiatives digitales du schéma directeur en s’appuyant sur des Centres d’Expertises (CdE) mutualisés et agiles

La soirée s’est conclue sur de nombreuses questions / réponses relatives à cette opération extrêmement importante et très complexe au plan culturel, pour le Groupe CDC

NB: Le compte-rendu intégral est réservé aux adhérents