Le 8 janvier 2018, le Club MOA a donné la parole à Jean Pierre HUIN, secrétaire du Club MOA.

Ingénieur du Conservatoire National des Arts et Métiers de formation, Jean-Pierre HUIN a exercé des fonctions variées au cours de sa carrière professionnelle, notamment comme Ingénieur système, spécialiste des problèmes de conception des programmes complexes, puis responsable d’équipes de maîtrise d’ouvrage. Aujourd’hui retraité, Jean-Pierre HUIN s’est intéressé très tôt à l’intelligence artificielle. Il a proposé de partager son intérêt avec l’ensemble des membres du Club, en présentant un « état de l’art » puis en abordant les répercussions du développement de l’IA sur la société dans les prochaines années.

1 Définition

Il est difficile de donner une définition de l’intelligence. C’est un concept flou qui dépend beaucoup de la personne qui en parle. On peut parler de l’intelligence mathématique, de l’intelligence analytique ou de l’intelligence de l’âme. Dans le cadre de l’IA, on peut tenter de définir l’intelligence par ses caractéristiques. Un système d’IA permet :

- D’apprendre

- De comprendre

- De s’adapter à des situations nouvelles

- De traiter une information en vue d’un objectif

- De communiquer avec son environnement

La caractéristique qui peut donner lieu à une controverse est la « Compréhension » qui est une notion par essence complexe.

Apparition de l’IA

L’IA repose sur une conjecture, et suppose :

- Que les caractéristiques de l’intelligence humaine puissent être précisément décrites

- Qu’une machine soit capable de simuler ces caractéristiques

L’IA apparaît dès que deux processus parallèles arrivent à maturité et se rejoignent:

- L’évolution des idées concernant la nature de l’intelligence et de la pensée humaine

- L’invention de machines capable de traiter de l’information et en particulier de calculer

L’IA est une discipline à la croisée des chemins. Elle fait appel notamment à :

- La philosophie (Raisonnement, logique)

- Les mathématiques (Logique, simulation, probabilités, statistiques)

- La linguistique (Syntaxe, sémantique)

- L’informatique (Méthodes, outils)

- La biologie (Génomique, mimétisme)

- Les neurosciences (Simulation, mimétisme, modélisation)

- La psychologie (Reconnaissance, modèles cognitifs)

2 Historique

Rapidement évoquées, les réflexions et techniques de base de l’IA datent des années 1940 / 1950. JP HUIN cite quelques scientifiques dont les contributions à la naissance de cette discipline ont été fondamentales.

- Norbert WIENER Le père de la cybernétique, voyait l’intelligence comme une boite noire fonctionnant essentiellement sur des processus de feedback

- Warren Mc CULLOCH et Walter PITTS inventeurs du concept de neurone formel

- Donald HEBB, inventeur de la règle qui porte son nom et qui décrit le fonctionnement d’un processus de mémoire et de fonctionnement entre deux neurones.

- Herbert SIMON inventeur du concept de rationalité et Allen NEWELL utilisant le concept d’heuristique pour modéliser le processus de décision du cerveau.

Traditionnellement on fixe la naissance de l’IA en 1956, au Dartmouth College, où 4 scientifiques (J. Mc CARTHY, M. MINSKY, N. ROCHESTER, C.E SHANNON) posent les bases de ce qui deviendra l’IA.

A partir de cette époque de nombreux scientifiques vont apporter leur pierre à l’édifice :

F. ROSENBLATT, H. GELERNTER, O. SELFRIDGE, N. CHOMSKY, E. FEIGENBAUM, E. SHORTLIFFE, J. HOPFIELD et d’autres. La discipline connaît durant ces 60 ans des périodes d’enthousiasme et de déprime tant sur le plan scientifique que sur le plan financier et même moral.

Se demander si un ordinateur sait penser est aussi intéressant que se demander si un sous-marin sait nager. (Edsger DIJKSTRA)

L’IA demain

- Aujourd’hui : Une informatique encore traditionnelle – Algorithme fait à la main

- En cours : Le deep learning – des Réseaux de neurones de 10 à 30 couches – non auditable

- Demain : Une IA de transfert learning. Quand on sait quelque chose dans un secteur on peut l’appliquer à un autre secteur. (2025 / 2035)

- Après-demain ou jamais : Une IA dotée d’une conscience artificielle (film Ex-Machina) Une IA qui aurait un but propre et qui ne serai pas seulement à notre service.

3 Le modèle biologique

A partir du moment où on parle de neurone formel, il convient de décrire le neurone naturel et son fonctionnement afin de mesurer avec exactitude la différence entre les deux et en quoi cette dénomination peut prêter à des erreurs d’interprétation.

Le neurone est une cellule particulière, constitutive du cerveau humain. Chaque personne en compte environ entre 86 et 90 milliards. Chaque neurone est connecté à d’autres neurones via un système synaptique. Le nombre de synapses auquel un neurone est connecté varie de 1 à 100 000, en moyenne 10 000 connexions pour un neurone.

Une animation a clairement montré le fonctionnement d’un neurone et le mécanisme de la transmission des signaux. (Transmission saltatoire)

4 Le concept d’apprentissage

Dans cette partie de l’exposé, JP HUIN a expliqué le mécanisme de base du « Machine Learning » à partir d’un exemple simple : Au cours d’une promenade en forêt le relevé, pour une même essence d’arbre, de deux caractéristiques ! Hauteur et diamètre du tronc. L’ensemble des mesures peut-être porté sur un graphique orthonormé. Une régression linéaire (donc calcul du coefficient angulaire, a, et de l’ordonnée à l’origine, b) permet de faire une prédiction de la hauteur d’un arbre pour un diamètre connu. Une autre manière d’aborder la problématique et de mettre en place un algorithme qui va faire varier a et b et trouver les meilleures valeurs qui vont définir une droite passant le plus près possible de tous les points du graphique.

Le « Machine Learning » consiste à « éduquer » un système de sorte que lorsqu’on lui confie des données d’entrée, il soit capable de réaliser une prédiction sur les données de sortie.

Dans l’exemple ci-dessus, on entre le diamètre du tronc et le système prédit la hauteur de l’arbre. Il est assez facile de comprendre que plus l’éducation du système sera complète et dense plus la prédiction sera bonne.

Exemple opérationnel : détection de fraude à la carte de paiement. On entre des données telles que nature de la transaction, lieu, montant, date et on demande à l’algorithme si la transaction est une tentative de fraude.

En matière d’IA, une des applications phare du « Machine Learning » est la reconnaissance d’image. On présente à l’algorithme une image et on lui demande de déterminer si c’est un fruit, une lampe, une voiture ou un chat. C’est un problème très complexe.

5 Le « Deep Learning »

Le « Deep Learning » est un cas particulier du « Machine Learning ». Il repose sur la mise en réseau de neurone formel (ou neurone artificiel).

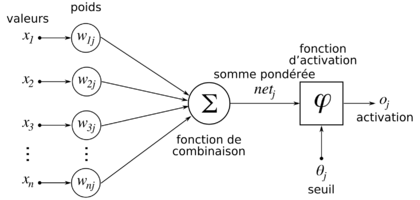

Le neurone formel

Un neurone formel est une construction mathématique, (analogue à la droite précédente) qui met en relation des entrées et une sortie.

A chaque entrée on affecte un coefficient (poids synaptique). Ce poids varie et peut s’ajuster. Quand la somme est supérieure à S le neurone artificiel renvoie 1, sinon il renvoie 0. Les poids sont comme les coefficients a et b de la droite précédente.

Un neurone seul ne fait pas grand-chose. On les « empile » pour réaliser des fonctions très complexes. On obtient un réseau de neurones artificiels

Un réseau de neurones n’est pas fait pour reproduire le fonctionnement de notre cerveau, c’est juste une construction mathématique qui s’en inspire. Ces réseaux de neurones sont polyvalents. On peut les adapter à un grand nombre d’entrées et de sorties. Mais conceptuellement on les utilise comme la droite du premier exemple.

Premier point fondamental.

Les réseaux de neurones sont spécialisés. Si, par exemple, on entraîne un réseau de neurones à analyser des radiographies du thorax, il sera incapable de reconnaître une automobile sur une image. Ceci est un point fondamental des technologies et développements actuels.

Second point fondamental

La mise en œuvre d’un réseau de neurones comprend deux étapes.

La première est l’éducation. On présente au réseau un ensemble d’entrées, par exemple des images d’automobile. Un algorithme ajuste au fil de l’apprentissage les poids synaptiques de chaque neurone(Pn) et les seuils S. Plus on présente d’exemples (en général plusieurs centaines de milliers) plus le réseau sera performant.

Lorsque c’est terminé le réseau est prêt. Il est capable de faire une prédiction si on lui présente une nouvelle entrée. Le modèle est du type « Boite Noire » on ne sait pas interpréter la fonction mathématique qui a été mise en jeu. C’est un second point fondamental.

Types d’apprentissage

- apprentissage supervisé : le système dispose d’exemples sous forme de couples (entrée, sortie attendue), et parfois de contre exemples et est capable de construire statistiquement une règle de décision qu’il appliquera par analogie.

- apprentissage non supervisé : le système dispose d’entrées uniquement et les classe selon des critères, essentiellement statistiques, qu’il appliquera pour discriminer les nouvelles entrées.

La reconnaissance d’image a vraiment démarré en 2012. Lors du concours annuel de performance des algorithmes de reconnaissance d’images du «Stanford Vision Lab » un algorithme de « Deep learning » a pulvérisé les performances. Paul WERBOS, Geoffrey HINTON, Yann LECUN sont les principaux artisans de cette réussite qui a relancé la discipline. Ils ont mis au point les algorithmes basés sur la rétro-propagation du gradient d’erreur inventé par John HOPFIELD. Ces techniques, qui sont grosses consommatrices de puissance de calcul, s’appuient sur les GPU (graphic Processor Unit) dont la puissance a littéralement explosé depuis quelques années. Enfin, le dernier élément accélérateur est la mise à disposition de centaines de millions d’images disponibles sur les réseaux internet. Ces images permettent une excellente éducation des réseaux. Chaque jour 800 millions d’images sont ajoutées sur Facebook, par exemple.

Actuellement on peut fabriquer des réseaux qui ont une centaine de couches et plusieurs millions de neurones artificiels.

Enfin, le plus intriguant (et le plus étonnant), reste la capacité à transformer les réseaux « Deep Learning » en modèle génératif. Un réseau de neurones entraîné, par exemple à reconnaître des images de motos, peut être transformé en modèle génératif. On lui demande de générer des images de motos et il est capable de générer des milliers d’images différentes de motos.

IA forte et IA faible

Les spécialistes ne sont pas tous d’accord sur la définition ci-après.

IA FORTE : l’intelligence artificielle forte, ou ascendante, est l’approche la plus similaire du comportement humain.

IA FAIBLE : l’IA faible, ou descendante, vise principalement à reproduire le plus fidèlement possible, à l’aide d’un programme informatique, le résultat d’un comportement spécifique observé à l’avance et ne donnant pas d’application non prévue.

En suivant cette définition, observons que tous les systèmes actuels relèvent de l’IA faible.

6 Au cœur du sujet

L’IA nous renvoie à des questions importantes :

- L’accélération technologique

- La violence : drones tueurs autonomes

- L’impréparation : Le monde politique semble absent, l’école n’enseigne pas comment vivre et travailler avec des systèmes IA, le pays ne semble pas prêt à la révolution qui avance.

- Un trou noir de valeurs : Les entreprises qui ne sont pas dans l’IA ou qui ne l’utilisent pas prennent des risques importants. Les GAFAM et BATX approchent les 1000 milliards de dollars de capitalisation boursière.

Exemple : WHATSAPP, 4 ans d’existence, 55 salariés, vendu 23 milliards de dollars à Facebook !

- Une désynchronisation entre le temps politique et le temps technologique

- La notion d’IA renvoie au QI des personnes. Lorsque tout sera automatisé que deviendront ces naufragés du numérique.

- L’IA génère un vertige démocratique : ce sont les entrepreneurs qui créent et organisent le futur.

- La fin de la vie privée à cause des réseaux sociaux mais également à cause des capacités d’analyse de l’IA

- L’augmentation des écarts : la concentration des richesses, la superposition des pouvoirs aux mêmes endroits.

- Enfin l’IA est-elle liberticide ?

Fiévreusement, l’homme vit ce paradoxe, prédit depuis si longtemps, par les maîtres de la science-fiction: il est servi par une technologie qui l’asservit. Une technologie qui, certes, le libère de contraintes matérielles. Mais une technologie liberticide. Car l’homme d’aujourd’hui gagne en confort et en efficacité ce qu’il perd déjà en secret et en liberté. (Frédéric SICARD – Bâtonnier du Barreau de Paris)

Une nouvelle économie

Cette nouvelle économie se caractérise par un phénomène de « plateformisation ». Les GAFAM, et autres Baidu, Tencent, Ali Baba ou Xiaomi sont les champions incontestés de ce schéma. Leur développement, appuyé sur les réseaux internet, est quasi-exponentiel.

De fait, nous sommes en présence d’une « oligopolisation » de l’économie.

Les sociétés et les personnes vont devoir s’adapter. Les métiers vont changer.

Exemples : Un système d’IA est capable de détecter 14 pathologies différentes en analysant des radios du thorax et ce en quelques secondes. (Annoncé par une université américaine en décembre 2017)

Des métiers vont disparaître, d’autres vont se révéler. Il est cependant probable que ces nouveaux métiers demandent des capacités intellectuelles importantes.

Une nouvelle société va progressivement émerger. La question qui va se poser et sur laquelle il convient probablement de réfléchir déjà :

Comment régule-t-on une société profondément inégalitaire avec un nouveau type d’inégalité : la complémentarité ou la non complémentarité des personnes face à l’IA ?

Il y a une énorme prime pour les personnes les plus intelligentes, les plus innovantes, les plus adaptables, les plus entreprenantes

Dans cette économie qui émerge, ceux qui ont déjà une position majeure sont clairement avantagés. On peut se référer à la loi de Metcalf (ref): « La valeur d’un réseau croit comme le carré du nombre des utilisateurs du réseau. ».A partir de ce postulat et en fonction de la situation que nous connaissons aujourd’hui il semble bien que l’Europe soit en grande difficulté. Pour conclure il est important de savoir que les algorithmes mis en œuvre dans les systèmes IA se valent. Ce qui fait la différence est le nombre d’items utilisés lors de la phase d’éducation.

En conclusion de cet exposé JP HUIN a tenté de cerner les risques et les espoirs que l’IA a fait naître, ainsi que les premiers éléments d’une nouvelle éthique : l’éthique du numérique, une nouvelle façon d’aborder la définition des valeurs et des responsabilités.

Robert METCALF : scientifique américain, fondateur de la société 3COM a participé également à la naissance d’Internet.